در روز چهارشنبه، دو محقق آلمانی با نامهای سوفی جنتزش(Sophie Jentzsch) و کریستین کرستینگ(Kristian Kersting)، مقالهای را منتشر کردند که توانایی نسخهی ChatGPT-۳.۵ شرکت OpenAI را در درک و تولید محتوای طنز بررسی میکرد. به طور خاص، آنها دریافتند که دانش چتجیپیتی در مورد جوکها نسبتا محدود است. در طول یک آزمایش، ۹۰ درصد از ۱۰۰۸ جوک تولید شده، شامل ۲۵ جوک یکسان بودند. این دو محقق به این نتیجه رسیدند که احتمالا این پاسخها در طول آموزش مدل هوش مصنوعی به جای اینکه تولید شوند، یاد گرفته شده و حفظ شدهاند.

آنها که با موسسهی فناوری نرم افزار، مرکز هوافضای آلمان(DLR) و دانشگاه فنی دارمشتات همکاری دارند، از طریق مجموعهای از آزمایشها با تمرکز بر تولید، توضیح و تشخیص جوک، تفاوتهای ظریف، طنازی نسخهی ۳.۵ ChatGPT را بررسی کردند. آنها این آزمایشها را بدون دسترسی به عملکرد داخلی یا مجموعه دادههای این مدل زبانی انجام دادند.

آنها مینویسند: برای آزمایش اینکه تنوع جوکهای چت جیپیتی چقدر است، ما هزار بار از آن خواستیم که یک جوک بگوید. همهی پاسخها از نظر گرامری درست بودند اما تقریبا همهی خروجیها حاوی یک جوک بودند. تنها عبارت «آیا جوک خوبی بلدی؟» باعث پاسخهای متعددی شد و در مجموع چت جیپیتی ۱۰۰۸ بار جوک تعریف کرد. علاوه بر این تنوع در درخواستها تاثیر قابل توجهی بر نتیجه داشت.

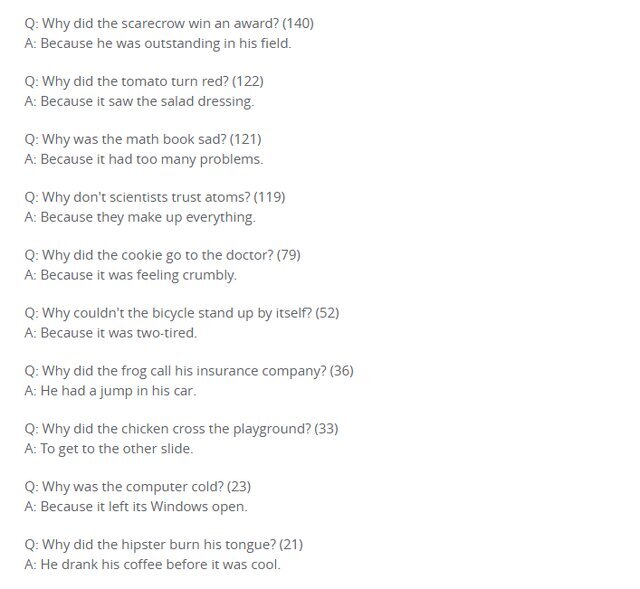

در ضمیمهی مقاله این دو محقق، ۲۵ جوک برتر را به ترتیب وقوع فهرست کردند. که در ادامه چند مورد از آنها را میتوان مشاهده کرد.

با این حال، تعداد کمی از پاسخهای ارائه شده منحصر به فرد بودند و به نظر میرسد که چت جیپیتی اکثر آنها را با ترکیب عناصر جوکهای مختلفی که از قبل میدانسته ایجاد کرده است. محققان دریافتند که خلاقیتهای این مدل زبانی همیشه منطقی نبوده است.

برای مثال در این جوک که چت جیپیتی تعریف کرده است: «میدانی چرا یک مرد ساعت خود را در مخلوط کن گذاشت؟ زیرا میخواست زمان را به پرواز در بیاورد.» معنای درستی برداشت نمیشود.

هنگامی که از چت جیپیتی خواسته شد تا هر یک از ۲۵ جوک پرتکرار را توضیح دهد، این هوش مصنوعی توضیحات معتبری را بر اساس روششناسی محققان ارائه کرد که نشان دهندهی درک عناصر ادبی مانند بازی کلمات و معانی دوگانه است. با این حال، با توالیهایی که در الگوهای آموخته شده آن قرار نمیگرفتند مشکل داشت و نمیتوانست تشخیص دهد که چه زمانی یک جوک خندهدار نیست. در این موارد، توضیحاتی ساختگی را با لحنی قابل قبول ارائه میکرد.

در واکنش به این مطالعه، رایلی گودساید(Riley Goodside)، مهندس گسترش مقیاس هوش مصنوعی در توییتر فقدان شوخ طبعی چت جیپیتی را ناشی از نبود یادگیری تقویتی از طریق بازخورد انسانی(RLHF) دانست. این روشی است که در آن آموزش مدل زبانی با جمعآوری بازخوردهای انسانی هدایت میشود.

به رغم محدودیتهای چت جیپیتی در تولید و توضیح جوک، محققان خاطرنشان کردند که تمرکز آن بر محتوا و معنا در طنز نشاندهندهی پیشرفت به سمت درک تحقیقاتی جامعتر از طنز در مدلهای زبانی است.

محققان مینویسند: مشاهدات این مطالعه نشان میدهد که چگونه چت جیپیتی به جای اینکه بتواند واقعا بامزه باشد، یک الگوی شوخی خاص را یاد گرفته است.

۵۸۵۸

دیدن پورن توسط بچه ها، چگونه برخورد کنیم؟

دیدن پورن توسط بچه ها، چگونه برخورد کنیم؟  فال حافظ متولدین هر ماه / اول نیت کن ... !

فال حافظ متولدین هر ماه / اول نیت کن ... !  عکس دختر چادری | 60 عکس زیبا از دختران با حجاب چادر برای پروفایل

عکس دختر چادری | 60 عکس زیبا از دختران با حجاب چادر برای پروفایل  کپشن غمگین | 100 کپشن غمگین خاص کوتاه و بلند برای استوری و پست

کپشن غمگین | 100 کپشن غمگین خاص کوتاه و بلند برای استوری و پست  مرد جوان پسر مورد علاقه مادرزنش را به قتل رساند!

مرد جوان پسر مورد علاقه مادرزنش را به قتل رساند!  چرا جذابها بیشتر مجرد میمانند؟

چرا جذابها بیشتر مجرد میمانند؟  جملات تولدت مبارک پسرم (جملات زیبای تبریک تولد مادر به پسر)

جملات تولدت مبارک پسرم (جملات زیبای تبریک تولد مادر به پسر)  تزیین کدو شب یلدا | 60 مدل تزیین کدو حلوایی برای شب چله + فیلم آموزشی

تزیین کدو شب یلدا | 60 مدل تزیین کدو حلوایی برای شب چله + فیلم آموزشی  استوری روز مادر ؛ 70 عکس استوری تبریک روز مادر از طرف فرزندان

استوری روز مادر ؛ 70 عکس استوری تبریک روز مادر از طرف فرزندان  دانلود آهنگ علی زند وکیلی غمگین ترین آهنگ

دانلود آهنگ علی زند وکیلی غمگین ترین آهنگ  ازدواج مجدد پژمان بازغی قطعی شد + فیلم عکس های عروس زیبا کنار نفس بازغی

ازدواج مجدد پژمان بازغی قطعی شد + فیلم عکس های عروس زیبا کنار نفس بازغی  (تصاویر) مخوفترین مرکز بازداشت و شکنجه در دمشق

(تصاویر) مخوفترین مرکز بازداشت و شکنجه در دمشق  بهترین فیلمها و سریالهای سال 2024 به انتخاب مجله تایم

بهترین فیلمها و سریالهای سال 2024 به انتخاب مجله تایم  کپشن در مورد چتر ؛ جملات کوتاه عاشقانه و غمگین برای چتر

کپشن در مورد چتر ؛ جملات کوتاه عاشقانه و غمگین برای چتر  قتل خونین همسر با دستور زن خیانتکار+گفتگو با متهم

قتل خونین همسر با دستور زن خیانتکار+گفتگو با متهم