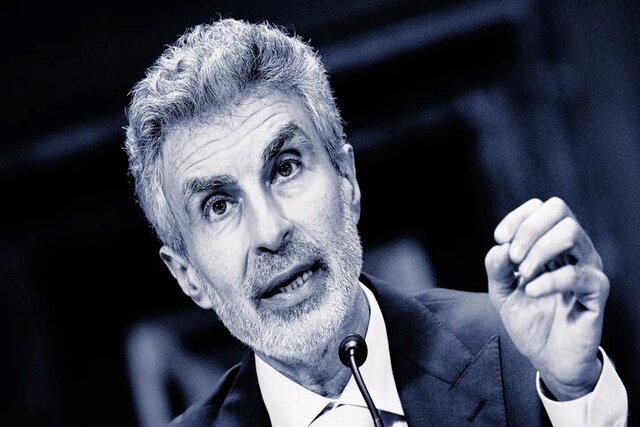

«پدرخوانده هوش مصنوعی» به کمپین مقابله با فجایع این فناوری پیوست

یوشوا بنجیو که یکی از پدرخواندههای هوش مصنوعی به شمار میرود، به پروژهای در بریتانیا برای جلوگیری از فجایع هوش مصنوعی پیوسته است. این برنده جایزه تورینگ معتقد است تنها راه تضمین ایمنی هوش مصنوعی، استفاده از نه انسان، بلکه همین فناوری برای بررسی...

یوشوا بنجیو که یکی از پدرخواندههای هوش مصنوعی به شمار میرود، به پروژهای در بریتانیا برای جلوگیری از فجایع هوش مصنوعی پیوسته است. این برنده جایزه تورینگ معتقد است تنها راه تضمین ایمنی هوش مصنوعی، استفاده از نه انسان، بلکه همین فناوری برای بررسی سایر سیستمهای هوش مصنوعی است.

به گزارش سینا به نقل از نشریه موسسه MIT، یوشوا بنجیو برنده جایزه تورینگ که یکی از پدرخواندههای هوش مصنوعی مدرن به حساب میآید، روی پروژهای که توسط دولت بریتانیا برای تعبیه مکانیسمهای ایمنی در سیستمهای هوش مصنوعی تعریف شده است، پیوسته است.

هدف این پروژه که Safeguarded AI نام دارد و به معنی «هوش مصنوعی محافظت شده» است، ساخت یک سیستم هوش مصنوعی است که بتواند بررسی کند که آیا سایر سیستمهای هوش مصنوعی مستقر در مناطق حیاتی ایمن هستند یا خیر.

بنجیو به عنوان مدیر علمی به این پروژه ملحق میشود و مشاورههای انتقادی و توصیههای علمی را ارائه میدهد. این پروژه که طی چهار سال آینده ۵۹ میلیون پوند اعتبار دریافت خواهد کرد، توسط آژانس تحقیقات و اختراعات پیشرفته بریتانیا(ARIA) تامین مالی میشود که در ژانویه سال گذشته برای سرمایه گذاری در تحقیقات علمی بالقوه تحولآفرین راهاندازی شد.

دیوید دالریمپل، مدیر برنامه هوش مصنوعی محافظت شده در ARIA میگوید هدف «هوش مصنوعی محافظتشده» ساخت سیستمهای هوش مصنوعی است که میتوانند تضمینهای کمی در مورد تأثیر آنها بر دنیای واقعی ارائه دهند. ایده این است که آزمایش انسانی را با تجزیه و تحلیل ریاضی پتانسیل آسیبرسانی سیستمهای جدید تکمیل کند.

هدف این پروژه ساخت مکانیسمهای ایمنی هوش مصنوعی با ترکیب مدلهای علمی جهان است که اساسا شبیهسازیهایی از جهان با اثباتهای ریاضی هستند. این شواهد شامل توضیحاتی درباره کار هوش مصنوعی میشود و انسانها وظیفه دارند بررسی کنند که آیا بررسیهای ایمنی مدل هوش مصنوعی درست است یا خیر.

بنجیو میگوید که میخواهد کمک کند تا این اطمینان حاصل شود که سیستمهای هوش مصنوعی آینده نتوانند آسیب جدی وارد کنند.

وی افزود: ما در حال حاضر در حال حرکت در مسیری مهآلود هستیم که ممکن است یک پرتگاه پیش رویمان باشد. ما نمیدانیم که پرتگاه چقدر دور یا نزدیک است یا حتی اصلا پرتگاهی وجود دارد یا نه. بنابراین ممکن است سالها یا دههها طول بکشد و نمیدانیم که چقدر میتواند جدی باشد. ما باید ابزارهایی را برای پاک کردن آن مه ایجاد کنیم و مطمئن شویم که اگر پرتگاهی وجود دارد به درون آن سقوط نکنیم.

بنجیو میگوید، شرکتهای علم و فناوری راهی برای ارائه تضمینهای ریاضی مبنی بر اینکه سیستمهای هوش مصنوعی طبق برنامهریزی رفتار خواهند کرد، ندارند. او میگوید که این غیرقابل اعتماد بودن میتواند به نتایج فاجعهباری منجر شود.

دالریمپل و بنجیو استدلال میکنند که تکنیکهای فعلی برای کاهش خطر سیستمهای هوش مصنوعی پیشرفته که در آن افراد سیستمهای هوش مصنوعی را برای یافتن نقصها بررسی میکنند، محدودیتهای جدی دارند و نمیتوان برای اطمینان از عدم کارکرد سیستمهای حیاتی به آنها اعتماد کرد.

در عوض آنها امیدوارند که این برنامه راههای جدیدی را برای ایمن کردن سیستمهای هوش مصنوعی ارائه دهد که کمتر به تلاشهای انسانی و بیشتر بر اطمینان ریاضی متکی باشند.

چشم انداز ساخت یک «هوش مصنوعی دروازهبان» است که وظیفه آن درک و کاهش خطرات ایمنی سایر عوامل هوش مصنوعی است. این دروازهبان تضمین میکند که عوامل هوش مصنوعی که در بخشهای پرمخاطره مانند سیستمهای حمل و نقل یا انرژی کار میکنند، همانطور که ما میخواهیم عمل کنند.

دالریمپل میگوید ایده این است که در ابتدا با شرکتها همکاری کنیم تا بفهمیم که مکانیسمهای ایمنی هوش مصنوعی چگونه میتوانند برای بخشهای مختلف مفید باشند.

بنجیو استدلال میکند که پیچیدگی سیستمهای پیشرفته به این معنی است که ما چارهای جز استفاده از هوش مصنوعی برای محافظت از هوش مصنوعی نداریم. این تنها راه است، زیرا در برخی مواقع این هوش مصنوعیها بسیار پیچیده هستند. حتی آنهایی که اکنون داریم.

مرحله بعدی ساخت مدلهایی است که میتوانند سیستمهای هوش مصنوعی دیگر را بررسی کنند. همچنین پروژه هوش مصنوعی محافظت شده و ARIA امیدوارند وضعیت موجود صنعت هوش مصنوعی را تغییر دهند.

ARIA همچنین به افراد یا سازمانها در بخشهای پرخطر مانند حملونقل، مخابرات، زنجیره تامین و تحقیقات پزشکی کمک مالی میکند تا به آنها کمک کند تا برنامههایی بسازند که ممکن است از مکانیسمهای ایمنی هوش مصنوعی بهرهمند شوند.

این سازمان در مجموع ۵.۴ میلیون پوند در سال اول و ۸.۲ میلیون پوند دیگر در سال بعد به متقاضیان ارائه میدهد و آخرین مهلت ارسال درخواستها تا دوم اکتبر است.

این آژانس همچنین شبکه گستردهای را برای افرادی که ممکن است علاقهمند به ساخت مکانیسم ایمنی Safeguarded AI از طریق یک سازمان غیرانتفاعی باشند، ایجاد میکند.

دالریمپل میگوید که این برنامه به دنبال پیشنهادهایی برای راهاندازی یک سازمان غیرانتفاعی با هیئت مدیره متنوع است که بخشهای مختلف زیادی را در بر گیرد تا این کار را به روشی قابل اعتماد انجام دهد. این مشابه همان کاری است که شرکت اوپنایآی(OpenAI) در ابتدا برای انجام آن قبل از تغییر استراتژی خود برای محصولمحوری و سود بیشتر راهاندازی شد.

هیئت مدیره این سازمان فقط مسئول پاسخگو کردن مدیر عامل نخواهد بود، بلکه حتی بر تصمیمگیریها در مورد انجام پروژههای تحقیقاتی خاص و انتشار مقالات و APIهای خاص تأثیر میگذارد.

پروژه «هوش مصنوعی حفاظت شده» بخشی از ماموریت بریتانیا برای مطرح کردن خود به عنوان یک پیشگام در حوزه ایمنی هوش مصنوعی است. این کشور در نوامبر ۲۰۲۳ میزبان اولین اجلاس ایمنی هوش مصنوعی بود که رهبران و فناوران جهان را گردهم آورد تا درباره چگونگی توسعه این فناوری به روشی ایمن بحث کنند.

دالریمپل میگوید در حالی که برنامه تأمین مالی برای متقاضیان مستقر در بریتانیا اولویت دارد، ARIA به دنبال استعدادهای جهانی است که ممکن است علاقهمند به آمدن به بریتانیا باشند.

آژانس ARIA همچنین دارای یک مکانیسم مالکیت معنوی برای تامین مالی شرکتهای انتفاعی در خارج از کشور است.

بنجیو میگوید، برای ارتقای همکاری بینالمللی در زمینه ایمنی هوش مصنوعی به این پروژه جذب شده است. او ریاست گزارش علمی بینالمللی در مورد ایمنی هوش مصنوعی پیشرفته را نیز بر عهده دارد که شامل ۳۰ کشور و همچنین اتحادیه اروپا و سازمان ملل میشود. او که مدافع سرسخت ایمنی هوش مصنوعی است، بخشی از یک لابی تأثیرگذار بوده است که هشدار میدهد هوش مصنوعی فوقهوشمند یک خطرِ وجودی دارد.

بنجیو میگوید: ما باید بحث در مورد چگونگی مقابله با خطرات هوش مصنوعی را به مجموعهای جهانی و بزرگتر بیاوریم و این برنامه ما را به این هدف نزدیکتر میکند.

(تصاویر) مخوفترین مرکز بازداشت و شکنجه در دمشق

(تصاویر) مخوفترین مرکز بازداشت و شکنجه در دمشق  آداب و رسوم شب یلدا در استان مازندران

آداب و رسوم شب یلدا در استان مازندران  ادوبی لوگوی جدیدی را برای فتوشاپ معرفی کرد

ادوبی لوگوی جدیدی را برای فتوشاپ معرفی کرد  شعر غمگین شب یلدا + مجموعه اشعار زیبای غم و ناراحتی شب یلدا

شعر غمگین شب یلدا + مجموعه اشعار زیبای غم و ناراحتی شب یلدا  دانلود آهنگ علی زند وکیلی غمگین ترین آهنگ

دانلود آهنگ علی زند وکیلی غمگین ترین آهنگ  کپشن در مورد چتر ؛ جملات کوتاه عاشقانه و غمگین برای چتر

کپشن در مورد چتر ؛ جملات کوتاه عاشقانه و غمگین برای چتر  متن زیبا برای شب یلدا با جملات بسیار زیبا و دلنشین

متن زیبا برای شب یلدا با جملات بسیار زیبا و دلنشین  کپشن غمگین | 100 کپشن غمگین خاص کوتاه و بلند برای استوری و پست

کپشن غمگین | 100 کپشن غمگین خاص کوتاه و بلند برای استوری و پست  زیباترین و شادترین عکس نوشته های شب یلدا

زیباترین و شادترین عکس نوشته های شب یلدا  ارسال و انتقال بوک مارک ها در مرورگر مایکروسافت Edge

ارسال و انتقال بوک مارک ها در مرورگر مایکروسافت Edge  مرد جوان پسر مورد علاقه مادرزنش را به قتل رساند!

مرد جوان پسر مورد علاقه مادرزنش را به قتل رساند!  سفره شب یلدا سنتی با تزیینات بسیار شیک

سفره شب یلدا سنتی با تزیینات بسیار شیک  زیباترین سفره های شب یلدا را ببینید + عکس

زیباترین سفره های شب یلدا را ببینید + عکس  دیدن پورن توسط بچه ها، چگونه برخورد کنیم؟

دیدن پورن توسط بچه ها، چگونه برخورد کنیم؟  قتل خونین همسر با دستور زن خیانتکار+گفتگو با متهم

قتل خونین همسر با دستور زن خیانتکار+گفتگو با متهم  گوشی Realme 14X معرفی شد؛ تراشه Dimensity 6300 و باتری 6000 mAh، فقط 175 دلار

گوشی Realme 14X معرفی شد؛ تراشه Dimensity 6300 و باتری 6000 mAh، فقط 175 دلار